Es gibt diese merkwürdigen Momente im Internet, in denen man kurz innehält, den Kopf schieflegt und sich fragt: Moment mal – ist dieses Video echt?

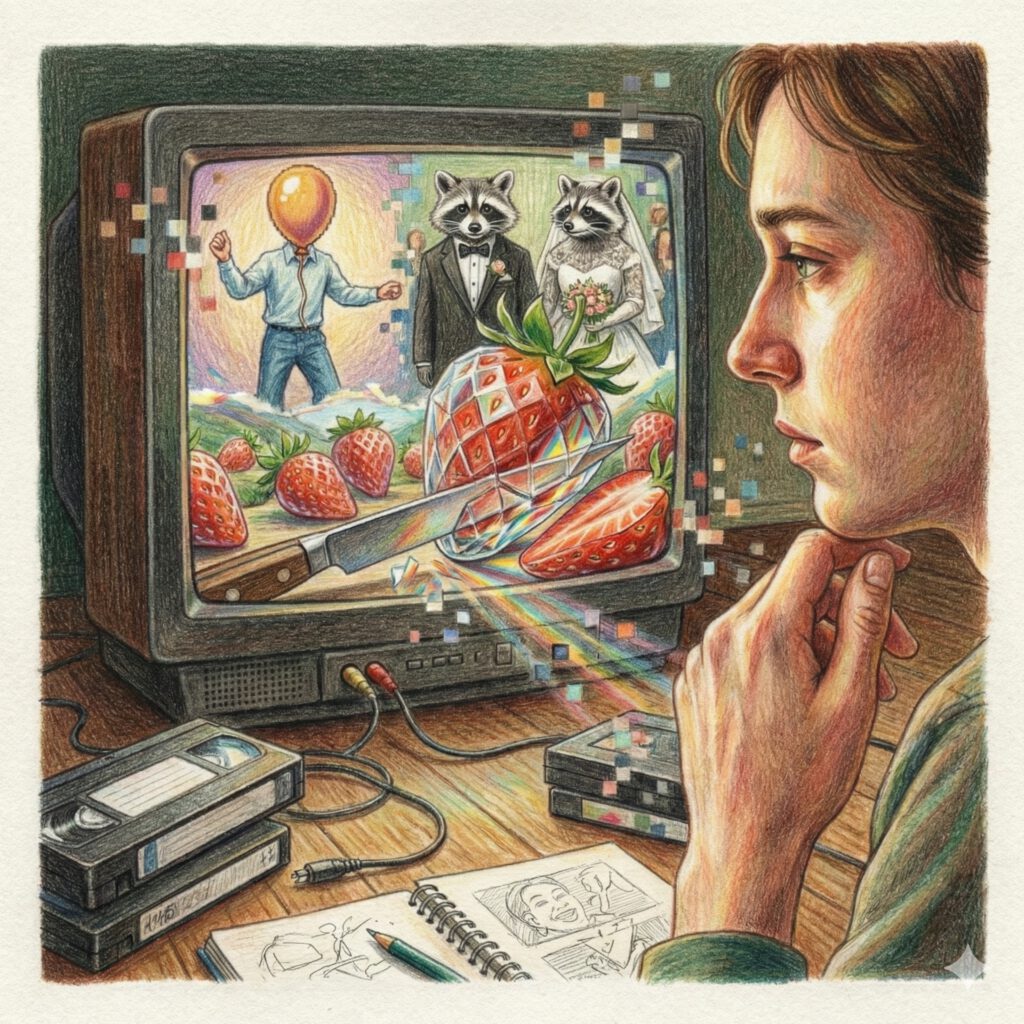

Zwischen 2016 und heute, Januar 2026, sind solche Momente zur täglichen Routine geworden. KI-Video tragen Namen wie „CCTV-Clip“, „Doorbell Camera“ oder „Glass Fruit ASMR“. Und diese KI-Videos zeigen springende Hasen, Katzen mit Banjos, gläserne Erdbeeren oder Menschen mit Luftballonköpfen. Was in weniger als einem Jahrzehnt passiert ist, lässt sich nicht als technischer Fortschritt beschreiben. Es ist eher eine visuelle Entkoppelung: Das Bild hat sich vom Licht gelöst, die Kamera ist optional geworden – und unser Verhältnis zur Realität wurde grundlegend neu verhandelt.

Willkommen zu einer Zeitreise durch zehn Jahre, in denen das Sehen selbst zur Debatte stand.

Die Vorgeschichte: Die Ära der sprechenden Köpfe (2016–2021)

Um zu verstehen, wo wir heute stehen, muss man in eine Zeit zurückblicken, als KI-Video noch etwas grundlegend anderes meinte. Zwischen 2016 und 2018 experimentierten Forschungslabore mit sogenannten Lip-Sync-Modellen. Die Idee war simpel: vorhandenes Filmmaterial nehmen und Münder neu berechnen, damit sie zu einer anderen Sprache passen. Das Ziel war Synchronisation, nicht Kreativität.

Der Begriff Deepfake tauchte erstmals auf zwielichtigen Reddit-Foren auf, begleitet von diffusem Unbehagen und technischer Faszination zugleich. Doch visuell blieb alles erstaunlich begrenzt: keine neuen Welten, keine Bewegung durch den Raum, nur Gesichter, die fast stimmten.

Als Synthesia 2019 öffentlich wurde, war das ein Meilenstein für Unternehmen. Plötzlich konnten Avatare Präsentationen halten, Compliance-Regeln erklären oder Produktschulungen durchführen. In dutzenden Sprachen. Effizient, skalierbar, kostengünstig. Aber auch: steril. Diese digitalen Sprecher waren korrekt, aber leblos. Ihnen fehlte das Zittern, das Zögern, die Mikro-Unordnung echten Lebens. Sie wirkten wie geschniegelte Nachrichtensprecher aus dem Uncanny Valley.

Noch war klar: KI ersetzt Menschen vor der Kamera. Nicht die Kamera selbst.

2022: Das Jahr, in dem KI träumen lernte

Dann kam 2022 – und mit ihm ein Paradigmenwechsel. Im Juli erschien CogVideo, ein chinesisches Open-Source-Projekt. Grob, sperrig, technisch anspruchsvoll. Aber revolutionär. Zum ersten Mal erzeugte reiner Text Bewegung über Zeit.

Kurz darauf begann ein Wettrennen der Tech-Giganten. Meta präsentierte Make-A-Video, Google antwortete mit Phenaki und Imagen Video. Die Ergebnisse waren kurz, verrauscht, fragmentiert, wie Träume, die man nicht ganz erinnern kann. Aber sie zeigten etwas Fundamentales: Die KI verstand jetzt Konzepte. Nicht nur Pixel, nicht nur Frames. Sondern Handlungen. Ein „Teddybär, der malt“ blieb über mehrere Sekunden hinweg ein malender Teddybär. Die Zeitachse hatte Bedeutung bekommen.

Das war nicht mehr nur Technik-Demo. Das war das Versprechen einer neuen visuellen Sprache.

2023: Runway und das Verschwinden der Kamera

Der eigentliche Durchbruch kam nicht aus einem verschlossenen Labor, sondern aus dem Browser. Im Februar 2023 öffnete Runway mit Gen-1 erstmals Text-to-Video für die Öffentlichkeit. Doch Gen-2, veröffentlicht im März, war der wahre Einschnitt: Jeder mit Internetanschluss konnte plötzlich Videos aus Text erzeugen.

Nicht perfekt. Noch längst nicht. Arme wuchsen zu zahlreich, Gesichter zerflossen, Hintergründe morphten ohne Rücksicht auf physikalische Logik. Aber das spielte keine Rolle. Das Internet tat, was es immer tut: Es fing an zu spielen. Die Kamera war kein physisches Objekt mehr, sondern ein Gedanke, den man tippen konnte.

Zum ersten Mal war KI-Video kein Privileg mehr. Es war ein Werkzeug. Demokratisiert, chaotisch, ungezähmt.

2024 Die Illusion der Echtheit – Vom digitalen Kino zum Ende des Beweises

Sora und der stille Schock

Als OpenAI im Frühjahr 2024 Sora vorstellte, veränderte sich etwas Grundlegendes. Nicht euphorisch, nicht laut, sondern still.

Das KI-Video bzw. der Clip, der die Welt innehalten ließ, hieß „Tokyo Street Walk“. Eine Frau in schwarzer Lederjacke läuft durch ein regennasses, neonbeleuchtetes Tokio. Lichter spiegeln sich in Pfützen. Die Kamera folgt ihr, schwenkt leicht, atmet. Es war keine Effekt-Orgie. Kein Gag. Einfach: Welt. Eine Szene, wie sie aus einem Wong-Kar-Wai-Film hätte stammen können.

Der Schock saß tief, weil nichts daran nach „KI“ schrie. Keine Übertreibung, keine morphenden Gesichter, keine physikalischen Fehler. Nur Realität, die nie existiert hatte.

Kurz darauf folgte „Air Head“ von der Produktionsfirma Shy Kids, ein poetischer Kurzfilm über einen Mann mit einem gelben Luftballon als Kopf. Konsistent, erzählerisch, emotional. Zum ersten Mal war KI-Video nicht Demo, sondern Kino.

Das Zeitalter der falschen Überwachungskameras

Während Sora das Hochglanz-Kino angriff, entstand in den Nischen der sozialen Medien etwas noch Wirkmächtigeres: ein Genre, das unser Urvertrauen in schlechte Bildqualität ausnutzte.

Es begann mit einem scheinbar banalen Clip: Springende Hasen auf einem Trampolin, gefilmt aus der Perspektive einer Überwachungskamera. Mittelmäßige Auflösung, statischer Winkel – genau das visuelle Vokabular, dem wir seit Jahrzehnten blind glauben. Das Video ging viral, weil es so unspektakulär wirkte. Erst bei genauer Analyse (WWLT: Viral “Bunnies on a Trampoline” Video Was AI – Here’s How It Fooled Everyone) wurde klar: komplett KI generiert.

Kurz darauf explodierte das Genre Katzen spielen Banjo an Türklingeln. Waschbären feiern Hochzeiten auf Terrassen. CCTV Captures Cats saving Kids From Bear Attacks.

Was hier entstand, war mehr als ein Trend. Es war ein mentaler Kipppunkt. Die KI hatte gelernt, dass körniges, verwackeltes Material nicht etwa verdächtig wirkt, sondern authentisch. Schlechte Bildqualität war kein Makel mehr, sondern ein Stilmittel. Die Überwachungskamera, einst Symbol dokumentarischer Wahrheit, wurde zur Theaterkulisse.

2025 Das Jahr des surrealen Alltags und der gläsernen Früchte

Das Unheimliche wird zum Meme

Wenn die Realität perfekt imitiert werden kann, flüchtet Kreativität oft ins Groteske. Der Trend „You Are What You Eat“ zeigte anthropomorphe Burger und Pizza-Menschen, die sich selbst verzehrten. Diese Videos waren absichtlich falsch, bewusst unheimlich und gerade deshalb erfolgreich. Sie nutzten das Uncanny Valley nicht als Bug, sondern als Feature.

Parallel dazu wurde historische Ikonografie zum Spielplatz. Wir sahen die Mona Lisa Pizza essen, Leonardo Da Vinci Paints Mona Lisa oder Ancient Roman empire AI video. Das Absurde wurde zur neuen Normalität.

In 2025 folgte die ironische Gegenbewegung: der „2004 Webcam Style“. Absichtlich verpixelte Clips zu Pop-Hits der Nullerjahre, ein digitaler Retro-Filter, der mit seiner eigenen Künstlichkeit kokettierte. In einer Welt perfekter 8K-Simulation wurde Imperfektion zum Luxus.

Glas, Früchte und die neue Materialität

Dann kam der Moment, der alles kondensierte. KI-Videos von gläsernen Erdbeeren, Grapefruits und Wassermelonen, die beim Schneiden wie Kristall klangen, aber wie echte Früchte safteten.

Diese Clips trafen etwas Tiefes. Sie kombinierten physikalische Unmöglichkeit mit taktiler Logik. Man konnte das Zerbrechen fast auf der Zunge spüren. Es war ASMR für eine Welt, die man nicht anfassen kann, Dalís schmelzende Uhren, aber in 4K und Zeitlupe.

KI-Video war plötzlich nicht mehr nur visuell, sondern sensorisch.

Wenn Marken träumen und stolpern

Als die Industrie die Technologie kommerzialisierte, wurde die Debatte emotional. Coca-Colas „Holidays Are Coming 2.0“ von Weihnachten 2024 war technisch makellos und wurde dennoch heftig kritisiert. Zu glatt. Zu seelenlos. Viele empfanden den Clip als Verrat an der nostalgischen Wärme des Originals.

Der Toys „R“ Us „The Origin“-Spot zeigte das andere Extrem: einen weichen, traumartigen Fiebertraum aus Erinnerung. Hier wurde deutlich: Wir akzeptieren KI leichter, wenn sie surreale Welten erschafft, als wenn sie versucht, unsere heiligen Erinnerungen zu simulieren.

Die Werkzeuge des Wandels: KI-Video Plattformen 2026

Heute hat sich der Markt sortiert. Es gibt Werkzeuge für jede Art von Träumen:

Generative Kernplattformen: OpenAI Sora, Kling AI, Luma Dream Machine, Google Veo. Sie sind die Regisseure der neuen visuellen Welt.

Kommunikatoren: HeyGen und Synthesia haben durch perfektes Lip-Syncing und Video-Translation Sprachbarrieren faktisch eingerissen.

Automatisierer: InVideo AI und Pictory befeuern die „Faceless Channels“ auf YouTube. Skript rein, Video raus. Effizient, aber oft so austauschbar wie Fast Food.

KI ersetzt hier kein Filmteam. Sie ersetzt die Zugangshürde. Das ist demokratisch – und macht nachdenklich zugleich.

| Plattform | Modell / Basis | Kostenlose Option | Gut geeignet für Trend: |

|---|---|---|---|

| ChatGPT | Sora 2 (OpenAI Modell) | Begrenzte Anzahl für Plus-Nutzer; Gratis-User via Microsoft Rewards / VPN | Identitätsvariationen & filmische Ästhetik |

| Google Gemini | Veo 3.1 (Google Modell) | Monatliches KI-Guthaben (ca. 200 Punkte) in Gemini Advanced | Lippensynchronisation & YouTube-Integration |

| Kling AI | Kling 2.0 | Tägliche Gratis-Credits bei Login | Physikalische Korrektheit (z.B. Flüssigkeiten) |

| Luma Dream Machine | Luma / Sora 2 Preview | Begrenzte monatliche Generations | Fake Memory Footage (VHS-Style) |

| HeyGen / Hedra | Eigene spezialisierte Modelle | 1–5 Credits pro Monat kostenlos | Sprechende Avatare & Selfie-Dialoge |

| Runway | Gen-3 / Gen-4 | Startguthaben für Neuregistrierung | World-Morphing & präzise Kameraführung |

| Grok (xAI) | Grok-3 / X-Video | Gelegentlicher Free-Access für verifizierte Profile; meist X-Premium nötig | Real-Time News Visuals & Ungefilterte Satire |

KI-Video Trends im Jahre 2026

2026 hat sich der Charakter von KI-Videos grundlegend verändert. Der technische Wow-Effekt ist verschwunden, geblieben ist die ästhetische Haltung. KI-Videos müssen nicht mehr beeindrucken, sondern wirken.

Ein zentraler Trend sind identitätsspielende Selfie-Transformationen. Aus einem einzigen Foto entstehen alternative Versionen derselben Person: als Zukunfts-Ich, als historische Figur oder als Bewohner einer anderen Realität. Besonders beliebt sind Dialoge zwischen „heutigem“ und „zukünftigem“ Ich. Möglich wird das durch deutlich verbesserte Gesichtskonsistenz und präzise Lippensynchronisation.

Parallel dazu boomt das World-Morphing, bei dem das eigene Zimmer mittels Video-to-Video Synthesis in Echtzeit zum Dschungel oder Filmset wird. Während High-Dopamine Ultra-Shorts durch KI-gesteuerten Takt-Schnitt für schnelle Unterhaltung sorgen, gewinnen gleichzeitig formlose Formate ohne Gesicht an Bedeutung. Videos aus der Perspektive von Alltagsgegenständen (Object-POV) oder surreale Materialstudien wirken rein sensorisch und überwinden Sprachbarrieren.

Ein weiterer emotionaler Trend ist Fake Memory Footage: KI-generierte „Erinnerungen“ in VHS- oder Webcam-Ästhetik spielen mit Nostalgie und zeigen, dass atmosphärische Glaubwürdigkeit oft schwerer wiegt als faktische Wahrheit. Charakteristisch für 2026 sind dabei lange, ruhige Einstellungen und bewusste Reduktion. KI-Video ist kein bloßer Effekt mehr, sondern ein präzises Erzählmittel, bei dem die menschliche Authentizität den Kern bildet.

Selbst ausprobieren: Sechs Prompts, die zeigen, was KI kann

Prompt 1: Selfie-basierte Identitätsvariationen – „Ein anderes mögliches Ich“

Worum geht’s: Aus einem neutralen Selfie entsteht eine alternative Version von dir, nicht als Gag, sondern als glaubwürdige Existenz in einer anderen Realität.

Prompt: Nutze das hochgeladene Selfie als Referenz. Erzeuge ein ruhiges, filmisches Video derselben Person in einer alternativen Realität. Die Person steht still, blickt leicht an der Kamera vorbei. Umgebung: gedämpftes Licht, realistische Materialien, glaubwürdige Architektur. Keine Effekte, keine Überzeichnung. Kamerabewegung: sehr langsamer Push-in. Stimmung: nachdenklich, ruhig, selbstverständlich. Dauer: ca. 8–12 Sekunden.

(Selfie optional, aber empfohlen)

Was du beobachten solltest: Ob das Gesicht über die gesamte Sequenz hinweg stabil bleibt oder subtil „driftet“, ob die Szene bewusst ruhig statt spektakulär wirkt und ob sich dabei das leise, aber eindringliche Gefühl einstellt: „Das bin ich – aber woanders.“

Funktioniert mit: Sora (über ChatGPT), Runway (Gen-3/Gen-4), Veo (über Google Gemini)

Prompt 2: Selfie-basierte Identitätsvariationen – Identitäts-Zeitachsen

Worum geht’s: Kein Dialog, kein Text im Bild, nur zwei Versionen derselben Person, die sich anschauen. Zeit wird visuell erzählt, nicht erklärt.

Prompt: Nutze das hochgeladene Selfie als Referenz. Ein ruhiges, filmisches Split-Screen-Video, das zwei Versionen derselben Person zeigt. Links: das gegenwärtige Ich. Rechts: das zukünftige Ich, natürlich gealtert, nur subtile Veränderungen. Beide behalten identische Gesichtsstruktur und einen ähnlichen Ausdrucksstil. Sie sprechen nicht. Sie blicken sich kurz an und schauen dann wieder weg. Das Licht ist weich, neutral und realistisch. Die Kamera bleibt vollständig unbewegt. Stimmung: nachdenklich, intim, still.

(Selfie optional, aber empfohlen)

Was du beobachten solltest: Wie subtil die Alterung wirkt, ob beide Versionen eindeutig dieselbe Person bleiben und ob die Stille stärker wirkt als Sprache.

Funktioniert mit: Veo (über Google Gemini), Kling AI, HeyGen (vereinfachte Version)

Prompt 3: Object-POV – Die Welt aus Sicht eines Gegenstands

Worum geht’s: Die Kamera ist kein Beobachter mehr, sondern ein Gegenstand, der still am Alltag teilnimmt.

Prompt: Erzeuge ein Video aus der Perspektive einer Kaffeetasse auf einem Küchentisch. Morgendliches Licht fällt durch ein Fenster, Staubpartikel sind sichtbar. Menschen bewegen sich unscharf im Hintergrund, bleiben anonym. Die Kamera bewegt sich minimal mit der Trägheit des Objekts. Keine Schnitte, keine Musik, nur visuelle Ruhe. Dauer: ca. 10 Sekunden.

Was du beobachten solltest: Ob sich die Kamerabewegung physikalisch plausibel anfühlt, die Szene trotz fehlender Handlung interessant bleibt und dabei eine stille Intimität entsteht.

Funktioniert mit: Luma, Runway

Prompt 4: Materialstudie – „Unmögliches Material, reale Logik“

Worum geht’s: Ein Objekt verhält sich materialisch widersprüchlich, aber visuell konsistent.

Prompt: Zeige eine Erdbeere, vollständig aus klarem Glas. Eine Klinge schneidet langsam hindurch. Das Glas splittert hörbar, gleichzeitig tritt roter Saft aus. Makroaufnahme, ruhiges Licht, neutrale Umgebung. Keine Kamerawechsel, Fokus auf Textur und Bewegung. Dauer: ca. 6–8 Sekunden.

Was du beobachten solltest: Ob Bruch, Klang und Bewegung stimmig zusammenpassen, ob die Unmöglichkeit innerhalb der Szene trotzdem logisch wirkt und ob das Video dadurch eine beinahe taktile, „anfassbare“ Wirkung entfaltet.

Funktioniert mit: Luma, Runway, Veo (via Gemini, falls verfügbar)

Prompt 5: Memory Footage – „Eine Erinnerung, die nie existierte“

Worum geht’s: Die KI erzeugt eine vertraute Erinnerung, die emotional glaubwürdig ist, unabhängig von Wahrheit.

Prompt: Erzeuge ein Video im Stil einer alten VHS-Heimaufnahme. Szene: Sommernachmittag, Kinder laufen durch einen Garten, unscharf und beiläufig. Farben leicht ausgewaschen, Bildrauschen sichtbar, leichte Überbelichtung. Kamera wirkt unbeholfen geführt. Keine klaren Gesichter, kein Fokus auf Einzelpersonen. Dauer: ca. 10–15 Sekunden.

Was du beobachten solltest: Ob das Video Nostalgie auslöst, obwohl du weißt, dass es erfunden ist, ob sich die Szene eher „erinnert“ als inszeniert anfühlt und ob die Unschärfe ihre Glaubwürdigkeit erhöht.

Funktioniert mit: Luma

Prompt 6: Ruhige Erzählung – „die Stille“

Worum geht’s: Dieser Trend setzt auf das Weglassen. Eine einzige Einstellung, die durch Licht und Schatten eine Geschichte erzählt, ohne dass viel passiert.

Prompt: Ununterbrochene Einstellung eines leeren Holzstuhls in einem dunklen Raum. Ein einzelner Lichtstrahl wandert langsam über die Maserung des Holzes. Staubpartikel tanzen im Licht. Am Ende des Videos fällt ein sanfter Schatten einer Person auf den Boden, die man aber nicht sieht. Melancholisch, ästhetisch, ruhig. Dauer: ca. 10 Sekunden.

Was du beobachten solltest: Das Spiel von Licht und Schatten und die Feinheit der Staubpartikel. Die emotionale Wirkung entsteht hier rein durch die Komposition.

Funktioniert mit: Google Gemini (Veo 3.1) oder Sora 2

Fazit: Das Ende der Unschuld

KI-Videos haben uns in diesen zehn Jahren nicht einfach belogen. Sie haben uns gezeigt, wie sehr wir Bildern zuvor bedingungslos geglaubt haben. Die Kamera ist nicht tot, aber sie ist nicht mehr unschuldig. Das Bild ist nicht mehr Beweis sondern Behauptung.

Vielleicht ist das die wichtigste Erkenntnis im Januar 2026: Nicht die Maschinen haben gelernt, Bilder zu machen, wir haben gelernt, sie neu zu lesen. Wir schauen nicht mehr nur hin; wir prüfen, wir fühlen, wir entscheiden neu, was uns berührt.

Die Frage lautet nicht mehr: „Ist das echt?“

Sondern: „Berührt es mich?“

Und jetzt entschuldigen Sie mich. Ich muss mir noch einmal ansehen, wie diese Waschbären auf der Terrasse Hochzeit feiern. Es ist generiert. Aber verdammt, sie sehen glücklich aus.

Dieser Beitrag entstand mit Unterstützung von Claude.ai Sonet 4.5. Die eingebetteten KI-Videos sind via YouTube verlinkt und wurden alle mit verschiedenen spezialisierten KI-Videogeneratoren generiert.

Hast Du die Prompts getestet? Was war Dein Ergebnis, lass es mich in den Kommentaren wissen.