1 Der Moment, in dem wir aufhörten, Bildern zu glauben

Es war ein Freitag im März 2023, und das Internet hatte ein neues Lieblingsbild: Papst Franziskus, eingekuschelt in eine weiße Daunenjacke von Balenciaga, Gesicht ernst, Hände vergraben in den Taschen, wie ein Streetwear-Model auf dem Weg zur Mailänder Fashion Week. Das Bild war so gut, dass selbst versierte Social-Media-Nutzer stockten. Die Falten der Jacke warfen realistische Schatten, das Licht fiel weich auf den Stoff, die Proportionen stimmten. Fast.

Wenige Wochen später: Donald Trump, angeblich verhaftet, umringt von Polizisten in dunkelblauen Uniformen. Dramatisches Licht, cineastische Komposition, ein Bild wie aus einem Thriller. Nur: Es war nie passiert. Beide Bilder stammten aus Midjourney v5, und beide markierten einen Wendepunkt. Nicht, weil die Technologie neu war – KI-Bildgeneratoren existierten seit Monaten. Sondern weil zum ersten Mal Millionen Menschen gleichzeitig realisierten: Wir können Fotografien nicht mehr trauen.

Die Frage war nicht mehr, ob KI-Bilder täuschen können. Die Frage war: Warum hatten wir ihnen überhaupt geglaubt? Und wie war es so weit gekommen?

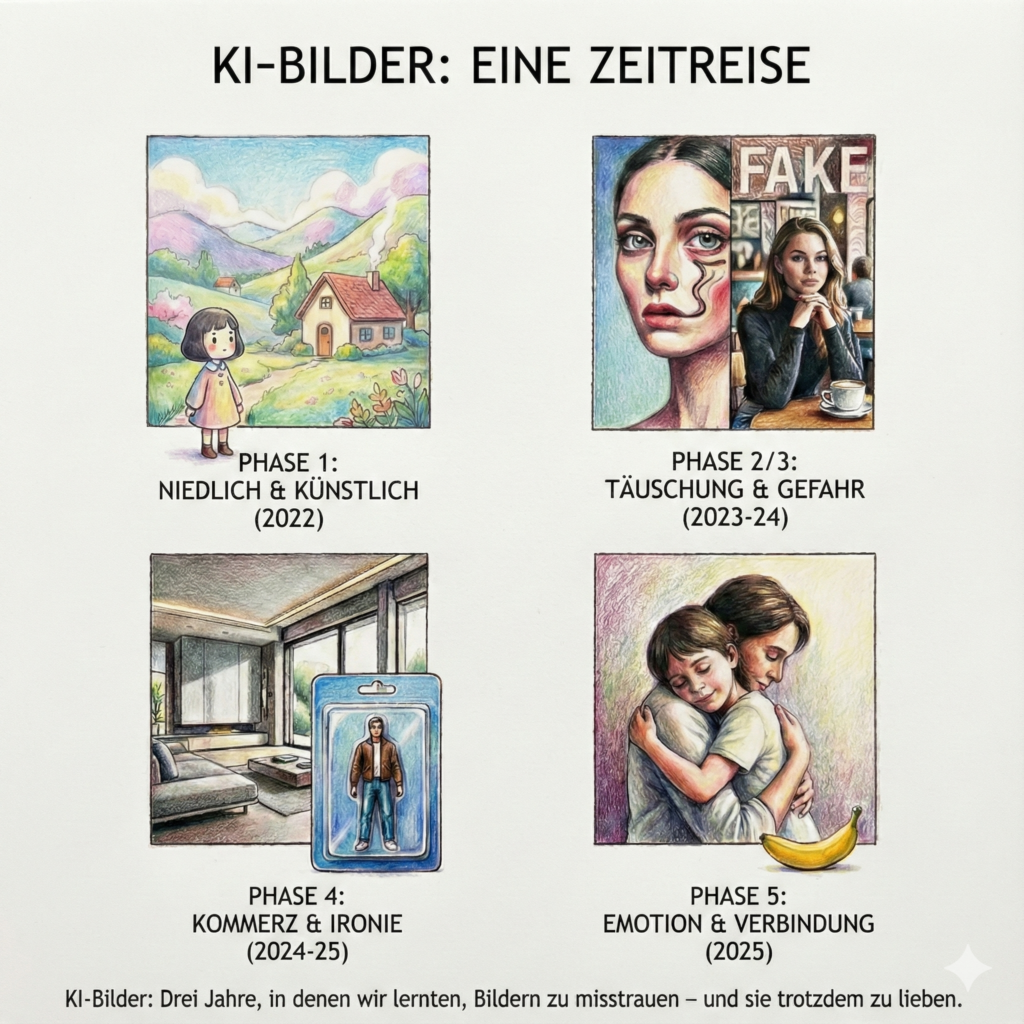

1.1 Phase 1: Als KI-Bilder noch niedlich waren

Rückblick, Ende 2022. KI-generierte Bilder waren damals vor allem eins: offensichtlich künstlich. Und genau das war ihr Charme. Midjourney v3 und v4 produzierten Bilder, die nicht vorgaben, real zu sein. Sie sahen aus wie Konzeptkunst aus einem Studio-Ghibli-Film: Pastellhimmel über sanften Hügeln, Häuser mit runden Fenstern, eine Wärme, die an analoge Kinderfilme erinnerte.

Die Ästhetik war unverkennbar: weiche Konturen, überzeichnete Farbpaletten, eine träumerische Qualität, die sofort als digitale Kunstform erkennbar war. Diese visuelle Sprache wurde zum Markenzeichen der frühen KI-Bildgenerierung – und die Community liebte sie genau dafür.

Doch es war nicht nur der japanische Anime-Stil, der die Algorithmen prägte. Parallel dazu imitierten KI-Modelle den Wes-Anderson-Stil – symmetrische Kompositionen, pastellfarbene Wände, Figuren in der Bildmitte, als hätte jemand die Ästhetik von „The Grand Budapest Hotel“ durch einen digitalen Filter gejagt.

Diese Bilder wurden massenhaft geteilt, nicht weil sie täuschten, sondern weil sie trösteten. In einer Welt, die zunehmend digital, schnell und kalt wirkte, boten sie einen „Comfy-Vibe“ – handgemacht wirkende Nostalgie aus der Maschine. Ein visueller Widerspruch, der funktionierte, gerade weil er keinen Realitätsanspruch hatte.

Die KI war in dieser Phase ein kreatives Spielzeug, kein Werkzeug der Desinformation. Die erkennbare Künstlichkeit war nicht nur akzeptiert – sie war gewollt. Niemand verwechselte diese Bilder mit Fotografien, und genau das machte sie harmlos. Doch diese Phase der visuellen Unschuld sollte nicht lange währen.

1.2 Phase 2: Kunst darf lügen

Parallel dazu entstand eine zweite Strömung: bewusst surreale, posthumane Ästhetik. KI-Künstler experimentierten mit verzerrten Körpern, unmöglichen Architekturen, organischen Formen, die aussahen wie Träume nach einer durchzechten Nacht. Gliedmaßen flossen ineinander, Gesichter wiederholten sich symmetrisch, Augen starrten aus unwahrscheinlichen Winkeln.

Diese Bilder bewegten sich bewusst im Raum der abstrakten Kunst. Sie wollten nicht dokumentieren, sondern verstören, faszinieren, zum Nachdenken anregen. Die Non-Fungible Token NFT-Szene feierte sie, Galerien stellten sie aus. Niemand empörte sich, weil niemand getäuscht wurde. Künstlichkeit war hier kein Bug, sondern das Feature.

Was diese Phase lehrte: Wir akzeptieren Künstlichkeit, solange sie sich zu erkennen gibt. Das Problem beginnt, wenn die Grenze verschwimmt.

1.3 Phase 3: Das gefährliche Spiel mit der Wahrnehmung

2024 brachte eine neue Qualität der Täuschung – und interessanterweise war sie weniger spektakulär als erwartet. Während ControlNet und ähnliche Technologien optische Illusionen ermöglichten – Landschaften, in denen versteckte Wörter oder Logos erst beim genauen Hinsehen sichtbar wurden –, geschah etwas Subtileres: KI begann, hyperrealistische Alltagsfotos zu erzeugen.

Keine Päpste in Designerjacken. Keine verhafteten Präsidenten. Sondern: Eine Frau in einem Café, die in ihr Handy schaut. Ein Mann an einer Bushaltestelle. Ein Kind, das einen Ball wirft. Perfektes Licht, natürliche Unschärfe, glaubwürdige Kompositionen. Das Problem? Diese Menschen existierten nie. Und genau das machte sie gefährlicher als jeder Promi-Fake.

Bei einem Bild von Donald Trump können wir recherchieren, Nachrichtenquellen prüfen, die Wahrheit herausfinden. Bei einem anonymen Alltagsfoto gibt es keine Referenz. Wir können es nicht überprüfen. Es zeigt nichts Spektakuläres, also haben wir keinen Grund zu zweifeln. Und genau da greift die Täuschung.

2024 zeigte: KI täuscht am effektivsten dort, wo wir gar nicht auf die Idee kommen, misstrauisch zu sein.

1.4 Phase 4: Kommerzialisierung und ironische Akzeptanz

Ende 2024, Anfang 2025 veränderte sich die Tonlage erneut. KI-Bilder wurden alltäglich. Werbekampagnen nutzten sie selbstverständlich, Architektur- und Innendesign-Accounts generierten hyperrealistische Renderings von nicht existierenden Räumen – Licht, das durch bodentiefe Fenster fiel, Schatten von Pflanzen auf Betonwänden, Materialien, die so perfekt aussahen, dass man sie anfassen wollte.

Erstellt mit DALL·E (OpenAI) (Quelle: Wikimedia Commons / Public Domain)

Der Realismus war da, aber die Sensation war weg. KI war keine Bedrohung mehr, sondern Infrastruktur. Ein Werkzeug wie Photoshop, nur schneller.

Und dann kam der Blisterverpackungs-Trend: Menschen, inszeniert wie Action-Figuren in durchsichtigen Plastikverpackungen, auf farbigen Pappkartons, mit glänzenden Reflexionen und Studio-Beleuchtung. Die Ausführung war technisch makellos – perfektes Plastik, realistische Falten, präzise Schatten. Aber der Inhalt war klar ironisch. Niemand glaubte, dass Menschen tatsächlich so verkauft wurden. Es war ein spielerischer Kommentar auf Konsumkultur, Selbstvermarktung, die Verdinglichung von Identität.

Diese Bilder zeigten: KI kann nicht nur täuschen, sondern auch reflektieren. Sie war erwachsen geworden – und mit ihr das Publikum. Wir hatten gelernt, mit dieser Technologie umzugehen, sie zu hinterfragen, aber auch ihren ästhetischen Wert zu schätzen.

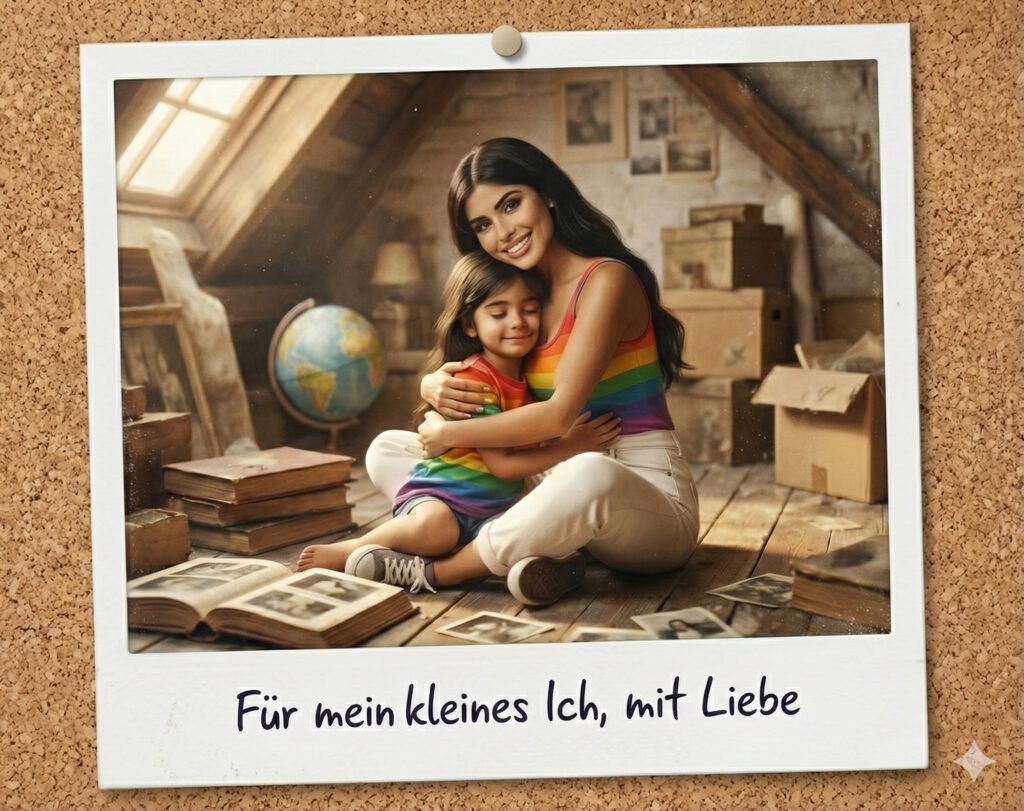

1.5 Phase 5: Wenn KI nicht mehr täuscht, sondern berührt

Herbst 2025. Ein neuer Trend eroberte die sozialen Netzwerke: „Hug Your Younger Self“. Menschen luden Kinderfotos hoch und ließen KI Bilder generieren, die zeigten, wie ihr heutiges Ich ihr jüngeres Selbst in den Arm nahm. Die Ausführung war erstaunlich – die KI verstand Perspektiven, Lichtverhältnisse, sogar die emotionale Körpersprache einer Umarmung. Die Bilder wirkten intim, zärtlich, manchmal fast schmerzhaft persönlich.

Gleichzeitig eroberte ein neuer Trend die sozialen Netzwerke: 3D-Figuren, die aussahen wie echte Sammlerstücke. Googles Gemini-Modell ermöglichte es plötzlich, gewöhnliche Fotos in hyperrealistische Miniaturfiguren zu verwandeln – Selfies wurden zu Action-Figuren, Haustiere zu Desk-Toys im Anime-Stil, Alltagsobjekte zu fotorealistischen Sammlerobjekten auf virtuellen Schreibtischen. Die Haptik war so überzeugend gerendert – Plastikglanz, Materialübergänge, winzige Schattenwürfe –, dass man unwillkürlich die Hand ausstrecken wollte, um sie anzufassen.

Was hier passierte, war ein qualitativer Sprung, kein rein technischer. KI-Bilder dokumentierten nicht mehr nur eine erfundene Realität. Sie erzeugten Emotionen. Sie wurden persönlich. Sie halfen Menschen, über Identität, Vergänglichkeit und Erinnerung nachzudenken.

Von der Fake-Maschine war KI zur Beziehungstechnologie geworden.

2 Die eigentliche Frage

Drei Jahre. Von Studio-Ghibli-Landschaften bis zu Bildern, die uns zum Weinen bringen. Von offensichtlich künstlich bis ununterscheidbar real. Von Spielzeug bis Infrastruktur. Die Geschwindigkeit dieser Entwicklung ist atemberaubend – und ein bisschen beunruhigend.

Wir haben gelernt, kritischer hinzusehen. Wir prüfen Quellen, wir hinterfragen Kontexte, wir entwickeln eine neue Form von visueller Alphabetisierung. Aber gleichzeitig hat sich unser Verhältnis zu Bildern grundlegend verändert. Ein Foto ist kein Beweis mehr. Eine Erinnerung kann gefälscht sein. Eine Emotion kann künstlich erzeugt werden – und trotzdem echt wirken.

Die zentrale Frage ist längst nicht mehr: „Ist dieses Bild echt?“ Die zentrale Frage lautet: „Warum glauben wir ihm – und was sagt das über uns?“

Denn am Ende geht es nicht um Pixel und Algorithmen. Es geht darum, was wir sehen wollen, was wir glauben wollen, was wir fühlen wollen. KI-Bilder haben uns nicht nur gezeigt, wie mächtig Technologie sein kann. Sie haben uns einen Spiegel vorgehalten – und wir sind noch dabei zu verstehen, was wir darin sehen.

Die nächsten drei Jahre werden zeigen, ob wir gelernt haben, damit umzugehen. Oder ob wir weiter durch eine Welt navigieren, in der wir nicht mehr wissen, welchen Bildern wir noch trauen können – und welchen wir trauen wollen.

3 Die Werkzeuge des Wandels: KI-Bildgeneratoren 2026

Drei Jahre sind eine Ewigkeit in der KI-Entwicklung. Was 2023 mit Midjourney v5 begann, hat sich 2026 zu einem vielfältigen Ökosystem entwickelt. Die zentrale Frage ist längst nicht mehr, ob KI-Bilder gut genug sind – sondern welches Tool für welchen Zweck am besten funktioniert.

Die Landschaft hat sich ausdifferenziert. Manche Modelle glänzen bei Text-im-Bild, andere bei anatomischer Präzision, wieder andere bei der emotionalen Inszenierung. Und das Beste: Die meisten sind inzwischen kostenlos zugänglich – zumindest in Grundversionen.

| Modell | Stärken | Bedienung | Kostenloser Zugang / Preis | Link |

|---|---|---|---|---|

| Nano Banana Pro(Google Gemini) | Material-Physik & 3D-Realismus; versteht Kontext am besten | Sehr einfach (Chat) | Ja (täglich begrenzt) / ca. 20€/Monat | gemini.google.com |

| Ideogram 3.0 | Marktführer für Text-im-Bild; ideal für Verpackungs-Designs | Einfach | Ja (10–25 Bilder/Tag) / ab ca. 7€/Monat | ideogram.ai |

| Leonardo.ai | Stilvielfalt (Anime, Film, Spielzeug); viele Regler | Mittel | Ja (150 Credits/Tag) / ab ca. 10€/Monat | leonardo.ai |

| ChatGPT (Image 1.5) | Beste Konversationsfähigkeit; iteratives Arbeiten | Sehr einfach (Chat) | Ja / 20€ (Plus-Abo) | chatgpt.com |

| Flux 2 (Black Forest) | Höchste anatomische Präzision; Open-Weight | Mittel bis Schwer | Ja (über Drittanbieter) | blackforestlabs.ai |

| Midjourney V7/V8 | Ästhetische Referenz; „schönste“ Bilder | Schwer (Discord/Web) | Nein (ab ca. 10€/Monat) | midjourney.com |

Nano Banana Pro – Googles inoffizieller Community-Name für Gemini – ist der intuitive Allrounder. Man chattet, beschreibt, iteriert. Die Material-Physik überzeugt: Plastikglanz, Stofffalten, Lichtbrechung wirken haptisch greifbar.

Ideogram 3.0 beherrscht, was andere verhunzen: leserliche Typografie im Bild. Für Blisterverpackungen oder Produkt-Mockups unschlagbar.

Leonardo.ai ist die Experimentier-Spielwiese mit unzähligen Stil-Voreinstellungen – für Einsteiger überfordernd, für Neugierige perfekt.

ChatGPT glänzt nicht durch Spitzenqualität, sondern durch Dialog. Iterieren, anpassen, weiterentwickeln – alles im Gespräch.

Flux 2 bietet maximale Kontrolle und Präzision – aber man braucht technisches Verständnis und Drittanbieter-Plattformen.

Midjourney produziert die ästhetisch überzeugendsten Bilder. Komposition, Farbharmonie, emotionale Wirkung – hier stimmt einfach alles. Der Preis: kein Gratis-Zugang mehr.

Die Wahl hängt weniger von Rankings ab als von der Frage: Was will ich erreichen? Experimentieren? Nano Banana oder Leonardo. Text-Designs? Ideogram. Höchste Ästhetik? Midjourney. Kommerzielle Sicherheit? Firefly. Maximale Kontrolle? Flux.

2026 ist KI-Bildgenerierung Infrastruktur. Man muss nicht alle Werkzeuge beherrschen – nur wissen, welches man wann braucht.

4 Selbst ausprobieren: Drei Prompts, die zeigen, was KI kann

Theorie ist gut. Praxis ist besser. Die beste Art, KI-Bildgenerierung zu verstehen, ist nicht, Artikel darüber zu lesen – sondern sie selbst auszuprobieren. Deshalb hier drei Prompts, die unterschiedliche Stärken aktueller Modelle demonstrieren. Such dir einen Generator aus der obigen Liste (Nano Banana Pro oder ChatGPT sind gute Einstiegspunkte), kopiere einen Prompt, und schau, was passiert.

Prompt 1: Der Actionfiguren-Blistershot

Worum geht’s: Dieser Prompt testet, wie gut die KI Materialien wie Plastik und Karton darstellt – und ob sie das kommerzielle Produktdesign einer Verpackung nachbilden kann.

Prompt: Eine hochwertige Sammler-Actionfigur in einer ungeöffneten Blisterverpackung (Mint in Box). Die Figur zeigt einen Cyberpunk-Ritter mit leuchtenden Neon-Akzenten. Die Verpackung hat eine klare, glänzende Plastikfront mit realistischen Lichtreflexionen. Die Rückseite besteht aus bedrucktem Karton mit modernem Grafikdesign und dem Text „NEON GUARDIAN – Limited Edition“. Studiobeleuchtung, Makroaufnahme, Fokus auf die Textur des Plastiks und die Details der Figur hinter der Scheibe, 8k Auflösung, Produktdesign-Fotografie.

Was du beobachten solltest: Wie realistisch wirkt die Plastikoberfläche? Sind die Lichtreflexionen glaubwürdig? Und – besonders spannend bei Ideogram – ist der Text lesbar?

Prompt 2: Der Anime-Stil

Worum geht’s: Moderne KI hat gelernt, nicht nur fotorealistisch zu sein, sondern auch stilistische Konventionen zu imitieren. Dieser Prompt zielt auf die Ästhetik hochwertiger Anime-Produktionen.

Prompt: Professionelles Anime-Key-Visual von einem Mädchen mit flammend roten Haaren in einer futuristischen Uniform. Stil: Moderner High-End-Anime (Ufotable/Makoto Shinkai Stil). Kräftige Farben, dynamische Pose, dramatisches Rim-Light (Kantenlicht). Der Hintergrund ist ein detailliertes neonbeleuchtetes Tokio bei Nacht mit weichem Bokeh. Saubere Linienführung, digitales Painting, 2D-Ästhetik mit cineastischer Lichtstimmung.

Was du beobachten solltest: Behält die KI den 2D-Look bei, oder rutscht sie in 3D-Rendering ab? Wie gut ist die Balance zwischen Detail und stilisierter Vereinfachung?

Prompt 3: Hyperrealistische Miniaturfiguren

Worum geht’s: Dieser Prompt ist eine Täuschungsprobe. Er fordert die KI auf, nicht nur eine Figur zu zeigen, sondern sie so darzustellen, als hätte jemand eine echte, handbemalte Miniatur fotografiert.

Prompt: Extreme Nahaufnahme (Makro-Fotografie) einer hyperrealistischen Miniaturfigur eines alten Zwergen-Schmieds. Man sieht feinste Details: die Textur der handbemalten Acrylfarbe, winzige Kratzer auf der Rüstung und die Materialität von Harz (Resin). Die Figur steht auf einer gestalteten Base mit realistischem Moos und Steinen. Sehr geringe Schärfentiefe (blurriger Hintergrund), Fokus auf das Gesicht der Figur. Natürliches Tageslicht von der Seite, wirkt wie ein echtes Foto in einem Hobby-Magazin.

Was du beobachten solltest: Sieht das Ergebnis aus wie ein Foto – oder wie CGI? Wie überzeugend ist die Unschärfe im Hintergrund? Und würdest du das Bild für echt halten, wenn du es ohne Kontext sehen würdest?

Ein letzter Tipp: Wenn du mit den Prompts experimentierst, variiere einzelne Elemente. Ersetze „Cyberpunk-Ritter“ durch „viktorianischer Detektiv“. Tausche „Tokio“ gegen „Venedig“. Ändere „Zwerg“ zu „Elfen-Kriegerin“. Noch spannender: Lade ein Selfie hoch und lass die KI dich als Actionfigur in einer Blisterverpackung inszenieren, als Anime-Charakter zeichnen oder als handbemalte Miniaturfigur darstellen (funktioniert bei den meisten Modellen – Nano Banana Pro und Midjourney machen es besonders gut). Die KI reagiert auf Nuancen – und genau das macht das Spielen mit ihr so faszinierend.

Am Ende wirst du verstehen, was dieser Artikel meint: KI-Bilder sind keine Magie. Sie sind ein Werkzeug. Und wie bei jedem Werkzeug entscheidet nicht die Technik über das Ergebnis – sondern das, was wir damit vorhaben.

Dieser Blogbeitrag ist mit Hilfe von Claude.ai Sonet 4.5 geschrieben worden. Die KI-Bilder stammen aus Wikimedia Commons oder sind von mir in Nano Banana Pro geprompted worden.

Hast Du die Prompts getestet? Was war Dein Ergebnis, lass es mich in den Kommentaren wissen.